Amazon Web Services ha dado un giro de tuerca a su estrategia en inteligencia artificial con una batería de anuncios que refuerzan tanto su catálogo de chips propios como su alianza tecnológica con Nvidia. En su gran conferencia anual de computación en la nube en Las Vegas, la compañía detalló cómo integrará tecnología de Nvidia en sus próximos procesadores de IA y presentó nuevos servidores diseñados para entrenamiento y despliegue de modelos a gran escala.

El movimiento sitúa a AWS en una posición aún más relevante dentro de la carrera por el cómputo de inteligencia artificial, un terreno donde compite directamente con otros gigantes como Microsoft, Google o Meta. Lejos de limitarse a revender GPU de terceros, Amazon apuesta por una combinación de chips propios, interconexiones especializadas y acuerdos con Nvidia para ofrecer a empresas europeas y globales más opciones de rendimiento y coste.

Trainium4: el próximo chip de Amazon hablará el idioma de Nvidia

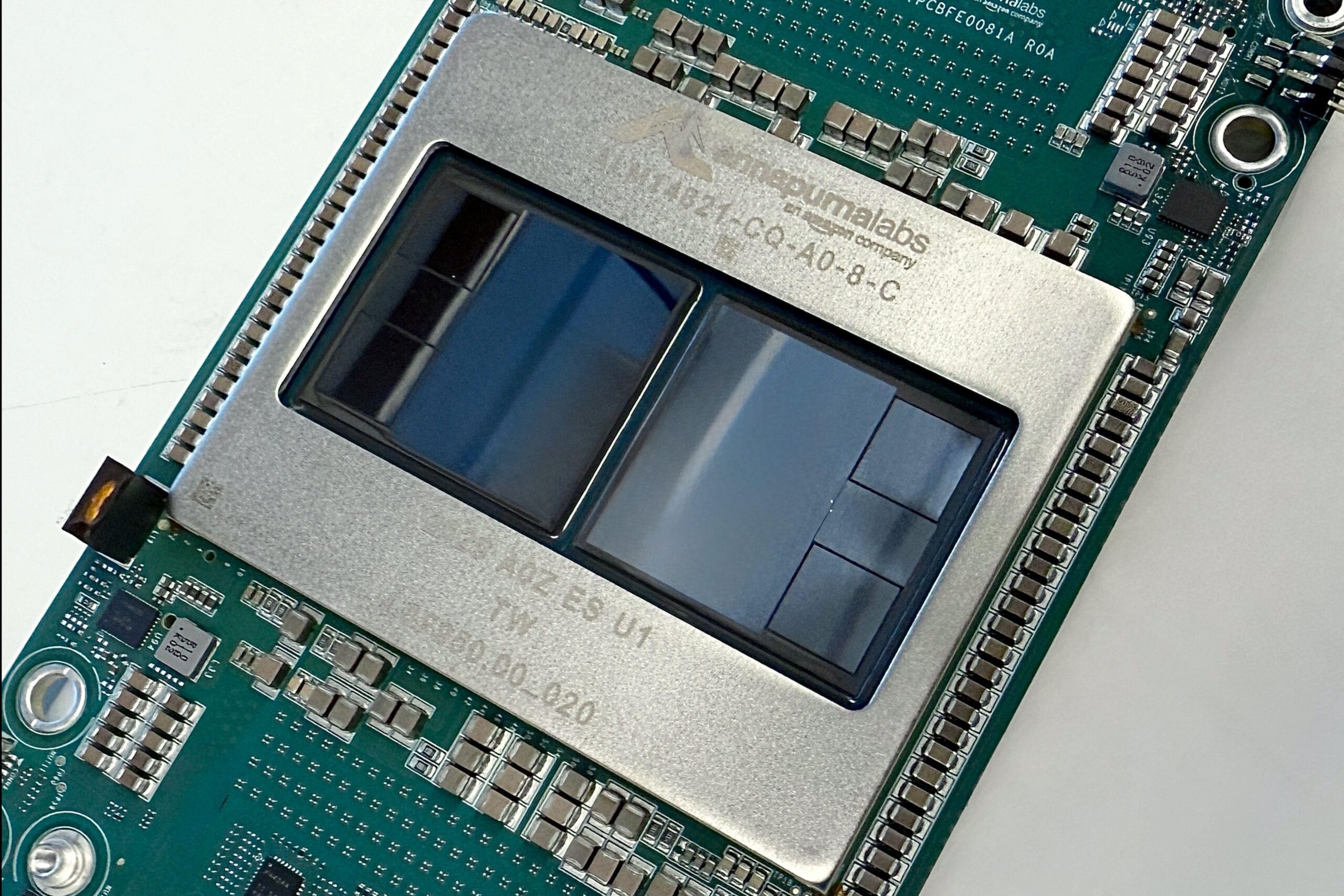

Uno de los anuncios más destacados fue la confirmación de que el futuro chip de entrenamiento de IA de la compañía, conocido como Trainium4, incorporará la tecnología de interconexión NVLink Fusion de Nvidia. Esta solución permite comunicaciones ultrarrápidas entre procesadores, algo crítico cuando miles de máquinas tienen que trabajar coordinadas para entrenar grandes modelos de lenguaje.

NVLink es considerada una de las grandes bazas de Nvidia en centros de datos de alto rendimiento, y hasta ahora se asociaba sobre todo a configuraciones puramente basadas en GPU de la propia compañía. La decisión de Amazon de integrar esta tecnología en Trainium4 implica que sus futuros clusters de IA podrán combinar chips de AWS y GPU Nvidia en la misma infraestructura, facilitando arquitecturas híbridas.

Aunque AWS no ha dado fechas concretas para la llegada al mercado de Trainium4, sí ha dejado claro el objetivo: ofrecer una plataforma que permita a los clientes seguir aprovechando el ecosistema de software de Nvidia, especialmente CUDA, mientras migran parte de sus cargas a hardware diseñado por Amazon en busca de mejor disponibilidad y precio.

Esta compatibilidad es especialmente relevante para organizaciones en Europa y España que ya se han estandarizado en torno a GPU Nvidia y bibliotecas optimizadas, pero que se están encontrando con limitaciones de capacidad o costes crecientes a la hora de escalar sus proyectos de IA generativa.

Nuevos servidores con Trainium3: más potencia y menos energía

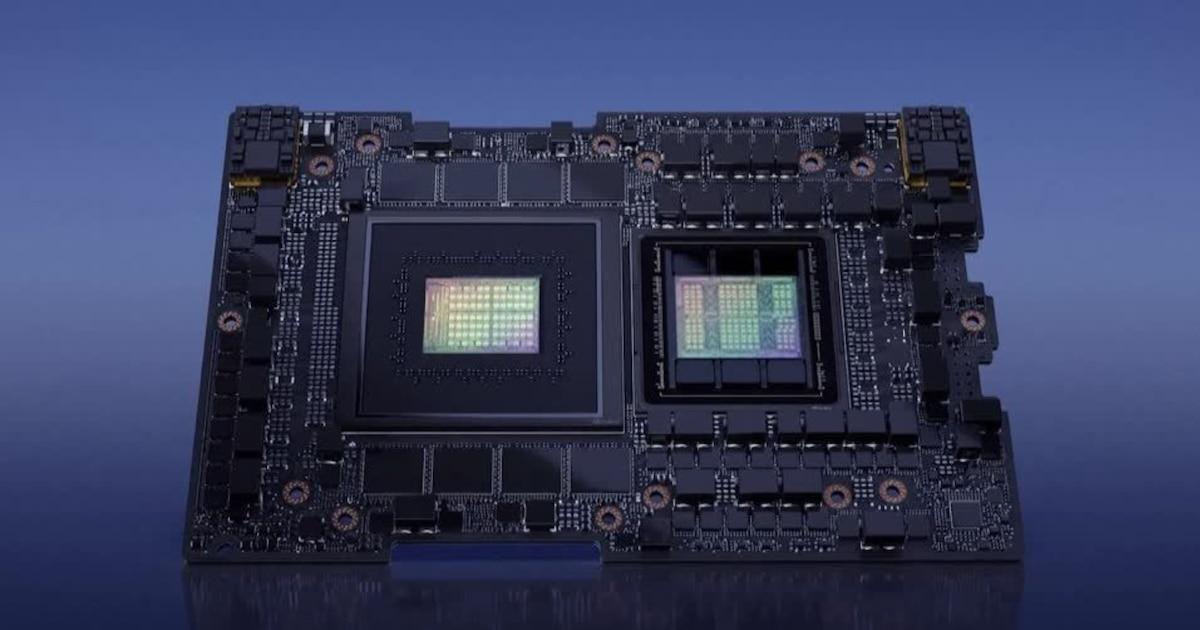

Mientras el desarrollo de Trainium4 avanza en segundo plano, AWS ya ha puesto en producción una nueva generación de servidores basada en el chip Trainium3. Estos equipos, disponibles desde la propia conferencia de Las Vegas, se orientan al entrenamiento de grandes modelos y a la inferencia de alto volumen en servicios de IA en la nube.

Cada servidor integra 144 chips Trainium3 y, según datos de la compañía, ofrece más de cuatro veces la capacidad de cómputo respecto a la generación previa de hardware de IA de AWS. Además, lo hace con un consumo energético aproximadamente un 40 % menor, un factor clave en un contexto en el que el coste de la electricidad y las restricciones de red empiezan a pesar en la expansión de los centros de datos.

Dave Brown, vicepresidente de servicios de computación y aprendizaje automático de AWS, subrayó que el objetivo no es únicamente presumir de potencia bruta, sino demostrar a los clientes que existe una alternativa competitiva en la relación precio-rendimiento frente a las GPU tradicionales. La compañía evita dar cifras absolutas, pero insiste en que el salto respecto a la generación anterior es notable.

Esta mejora de eficiencia resulta especialmente interesante para operadores europeos, donde la presión regulatoria y social sobre el consumo energético de las infraestructuras digitales es cada vez mayor. Menos electricidad para un mismo volumen de entrenamiento significa centros de datos más sostenibles y, potencialmente, facturas más contenidas para clientes empresariales.

Dentro de la hoja de ruta de Amazon, Trainium3 no solo busca ganar terreno frente a Nvidia, sino también reducir la dependencia de proveedores externos y afianzar una línea propia de chips de IA que pueda evolucionar con ciclos más controlados por la compañía.

Fábricas de IA: infraestructura dedicada en centros de datos propios

Otro de los anuncios que más atención ha generado es el lanzamiento de las llamadas Fábricas de IA de AWS, un producto pensado para grandes empresas y administraciones públicas que quieren ejecutar sistemas de inteligencia artificial avanzados en sus propios centros de datos, sin renunciar a la integración con la nube de Amazon.

El modelo es sencillo sobre el papel: el cliente aporta el espacio físico y la energía, y AWS se encarga de instalar, gestionar y mantener el sistema de IA, conectándolo con el resto de servicios de la plataforma. De este modo, compañías europeas con fuertes exigencias regulatorias, o gobiernos preocupados por la soberanía de los datos, pueden mantener el control total sobre la información sensible sin exponerla a infraestructuras ajenas.

El término Fábricas de IA no es casual. Nvidia utiliza ese mismo concepto para referirse a sus propios sistemas de hardware optimizados para inteligencia artificial, y en este caso la solución de AWS se construye precisamente en colaboración con el fabricante de GPU. Las Fábricas de IA de Amazon combinarán chips Blackwell de Nvidia y el nuevo Trainium3, apoyándose en la red, el almacenamiento y la seguridad de la nube de AWS.

Además del hardware, estas instalaciones podrán integrarse con servicios gestionados como Amazon Bedrock —para orquestar y desplegar modelos de IA fundacionales— y AWS SageMaker, orientado al desarrollo y entrenamiento de modelos propios. Para las empresas, esto significa un entorno de IA de alto rendimiento, pero desplegado bajo un esquema de nube híbrida que se adapta mejor a normativas locales de datos.

En paralelo, otros grandes proveedores como Microsoft también están avanzando en la misma dirección, con centros de datos y soluciones locales pensadas para soberanía de datos. La apuesta de Amazon con sus Fábricas de IA refleja hasta qué punto la inteligencia artificial está empujando a los gigantes de la nube hacia esquemas más híbridos, alejándose del modelo puramente centralizado de hace una década.

Modelos Nova, Sonic y el impulso a la oferta de IA de AWS

Junto a las novedades de hardware, Amazon aprovechó su conferencia para reforzar la parte de software con nuevas versiones de sus modelos de inteligencia artificial agrupados bajo la marca Nova. La compañía presentó Nova 2, una evolución que promete mayor velocidad y capacidad de respuesta frente a la generación anterior.

Una de las variantes de Nova es capaz de interactuar con los usuarios no solo mediante texto, sino también a través de imágenes, voz y vídeo, ampliando los casos de uso posibles en sectores como atención al cliente, educación en línea o creación de contenidos. Esta capacidad multimodal la sitúa en la misma liga que otras propuestas protagonistas del mercado de IA generativa.

Además, AWS mostró un modelo denominado Sonic, orientado a interacciones por voz. Según Matt Garman, director ejecutivo de Amazon Web Services, este sistema puede responder a instrucciones orales con salidas de voz de calidad «similar a la humana», lo que abre la puerta a asistentes conversacionales más naturales para servicios públicos y privados.

Aunque la compañía admite que sus modelos todavía tienen por delante el reto de ganar cuota de mercado frente a competidores como ChatGPT (OpenAI), Claude (Anthropic) o Gemini (Google), las cifras de negocio de AWS en el último trimestre apuntan a un crecimiento sólido. Las ventas de la división aumentaron alrededor de un 20 %, impulsadas en buena parte por la demanda de cómputo e infraestructura de IA.

Para el tejido empresarial europeo, esta ampliación de catálogo supone más opciones a la hora de elegir plataforma de IA, tanto en la vertiente de modelos listos para usar como en la de infraestructura sobre la que entrenar soluciones propias adaptadas a cada sector y regulación local.

Competencia feroz en la carrera de chips e infraestructura de IA

Todos estos lanzamientos se producen en un contexto de competencia intensa en el mercado de chips de inteligencia artificial. Nvidia mantiene una posición dominante gracias a sus GPU y a la fuerza de su ecosistema CUDA, pero compañías como Amazon, Google, Microsoft e incluso fabricantes tradicionales de procesadores están invirtiendo sumas millonarias para no quedarse atrás.

En el caso de AWS, la apuesta por Trainium3 y el futuro Trainium4 responde a una doble estrategia. Por un lado, busca reducir la dependencia de proveedores externos y controlar mejor los costes y la disponibilidad de su infraestructura. Por otro, quiere ofrecer a los clientes alternativas de hardware que permitan optimizar el gasto sin renunciar a rendimiento ni a compatibilidad con las herramientas de Nvidia.

Desde el punto de vista del mercado, la combinación de chips propios, acuerdos de colaboración con Nvidia y productos como las Fábricas de IA sitúa a Amazon como un actor capaz de competir no solo en servicios en la nube, sino también en la base misma del hardware que impulsa la nueva ola de aplicaciones de inteligencia artificial.

Para empresas y administraciones de España y Europa, este panorama se traduce en una oferta más amplia de infraestructuras posibles —desde la nube pública hasta centros de datos propios o híbridos—, con la posibilidad de elegir entre distintas configuraciones de precio, rendimiento y soberanía de datos. En un sector donde las decisiones tecnológicas tienen impacto directo en costes, cumplimiento normativo y capacidad de innovación, la llegada de Trainium3, las futuras integraciones con NVLink Fusion y las Fábricas de IA añade nuevas cartas a la baraja que, previsiblemente, acelerarán aún más la adopción de soluciones de inteligencia artificial a gran escala.