Controlar máquinas con gestos ha pasado de ser un recurso de ciencia ficción a una realidad que ya está en coches, robots, dispositivos médicos, videojuegos o viviendas inteligentes. Cada vez más sistemas son capaces de entender una mano levantada, un giro de muñeca o un simple movimiento del brazo y transformarlo en una orden concreta sin que tengamos que tocar una pantalla, un mando o un teclado.

Esta nueva forma de interacción se apoya en dos grandes pilares: la visión artificial y los sensores avanzados combinados con inteligencia artificial. Gracias a modelos de deep learning, cámaras RGB, sensores de profundidad, wearables de alta precisión y algoritmos muy finos para filtrar el ruido, hoy es posible pilotar drones, guiar cobots, manejar luces o navegar por un sistema de infoentretenimiento con un gesto natural y cómodo incluso en entornos llenos de vibraciones o movimiento.

Qué es exactamente el control gestual y por qué está despegando

Cuando hablamos de reconocimiento o control por gestos nos referimos a la capacidad de una máquina para “entender” movimientos humanos (de manos, brazos o del cuerpo entero) y traducirlos a acciones digitales. En vez de pulsar un botón o tocar una pantalla, basta con un gesto previamente definido para lanzar un comando.

En muchos sistemas modernos, sobre todo en los que dependen de cámaras, el foco está en las manos: las manos se detectan en la imagen, se hace seguimiento de su movimiento, se analiza su forma o la posición de los dedos y, a partir de ahí, se clasifica el gesto dentro de un conjunto conocido para activar una acción concreta.

Para lograrlo se entrenan modelos de visión artificial con grandes conjuntos de datos de imágenes y vídeos etiquetados con diferentes gestos. Cuanto más variados son los datos de entrenamiento (personas distintas, condiciones de luz diversas, fondos complejos, manos con guantes, etc.), mejor generaliza el modelo y más fiable es el reconocimiento en entornos reales.

En paralelo, han surgido soluciones que optan por sensores portables y wearables —como guantes táctiles con Arduino— colocados en la muñeca o integrados en la ropa, capaces de capturar microvariaciones de presión, aceleración y orientación del brazo. En estos casos el gesto se interpreta a partir de las señales de los sensores, sin necesidad de depender tanto de la cámara o de las condiciones de iluminación.

Tipos de gestos: estáticos, dinámicos y gestos cotidianos

En los sistemas de interacción humano-máquina, los gestos se suelen separar en gestos estáticos y gestos dinámicos. Esta distinción es clave porque condiciona la forma en que se diseñan los modelos de IA y los sensores necesarios.

Los gestos estáticos son posturas fijas de la mano o del cuerpo. Ejemplos típicos: pulgar hacia arriba, mano abierta en señal de “alto”, signo de la paz o un puño cerrado. Al no implicar movimiento, en la mayoría de los casos se pueden reconocer a partir de una sola imagen o de un instante concreto de señal en el wearable.

Los gestos dinámicos, en cambio, dependen de cómo se mueve la mano a lo largo del tiempo: saludar, deslizar el brazo hacia un lado, agitar la mano para pasar de pantalla o trazar un círculo en el aire para subir o bajar volumen. Aquí el sistema tiene que analizar una secuencia de fotogramas o de muestras del sensor para comprender la trayectoria y la velocidad del gesto.

En los dispositivos más avanzados, como algunos wearables de investigación, se llega a medir microgestos muy finos gracias a sensores flexibles de alta resolución, con precisión en torno a 0,01 grados de orientación. Esto permite distinguir variaciones de muñeca casi imperceptibles y aumentar así el repertorio de gestos posibles sin necesidad de equipos voluminosos o laboratorios controlados.

El papel de la visión artificial y las tareas clave de IA

Muchos de los sistemas que controlan máquinas con gestos se apoyan en algoritmos de visión artificial ejecutados en tiempo real. A partir de cámaras RGB estándar, sensores de profundidad o cámaras de tiempo de vuelo, la máquina puede ver lo que hace el usuario y reaccionar al instante sin que este deba llevar equipos adicionales.

Modelos modernos, como las familias tipo YOLO y otras arquitecturas de deep learning, permiten realizar en paralelo tareas como la detección y el seguimiento de objetos, la estimación de la postura de la mano o la segmentación píxel a píxel. En la práctica, las tareas de visión más frecuentes en control gestual son:

- Detección de objetos: localizar dónde están las manos en cada fotograma, normalmente dibujando cajas delimitadoras. Así el sistema se concentra en la zona relevante y reduce el ruido del fondo.

- Seguimiento de objetos: mantener la identidad de cada mano a lo largo del tiempo. Esto es imprescindible para gestos dinámicos y para evitar confusiones si hay varias personas en escena.

- Estimación de postura: extraer puntos clave de la mano (yemas, nudillos, muñeca) para construir un “esqueleto” simplificado que captura la forma y la curvatura de los dedos, ideal para distinguir gestos similares pero con posiciones de dedos diferentes.

- Segmentación de instancias: separar las manos del fondo a nivel de píxel y diferenciar cada mano (o cada persona) incluso cuando se solapan o aparecen muy juntas.

En un sistema real estas tareas suelen combinarse en un mismo flujo. Primero se detectan las manos, luego se hace seguimiento, después se estima la postura cuando hace falta detalle fino y, si el escenario es complejo o hay muchas personas, se recurre también a segmentación para mejorar la precisión.

Encima de esta capa de visión artificial se sitúa el módulo de clasificación de gestos, que toma como entrada la secuencia de posiciones o la forma de la mano y decide qué gesto se está realizando. Finalmente, otro módulo de software traduce ese gesto a una orden entendible para la máquina: pausar un vídeo, mover un robot, aceptar una llamada o encender una luz.

Wearables de alto rendimiento para controlar robots y máquinas

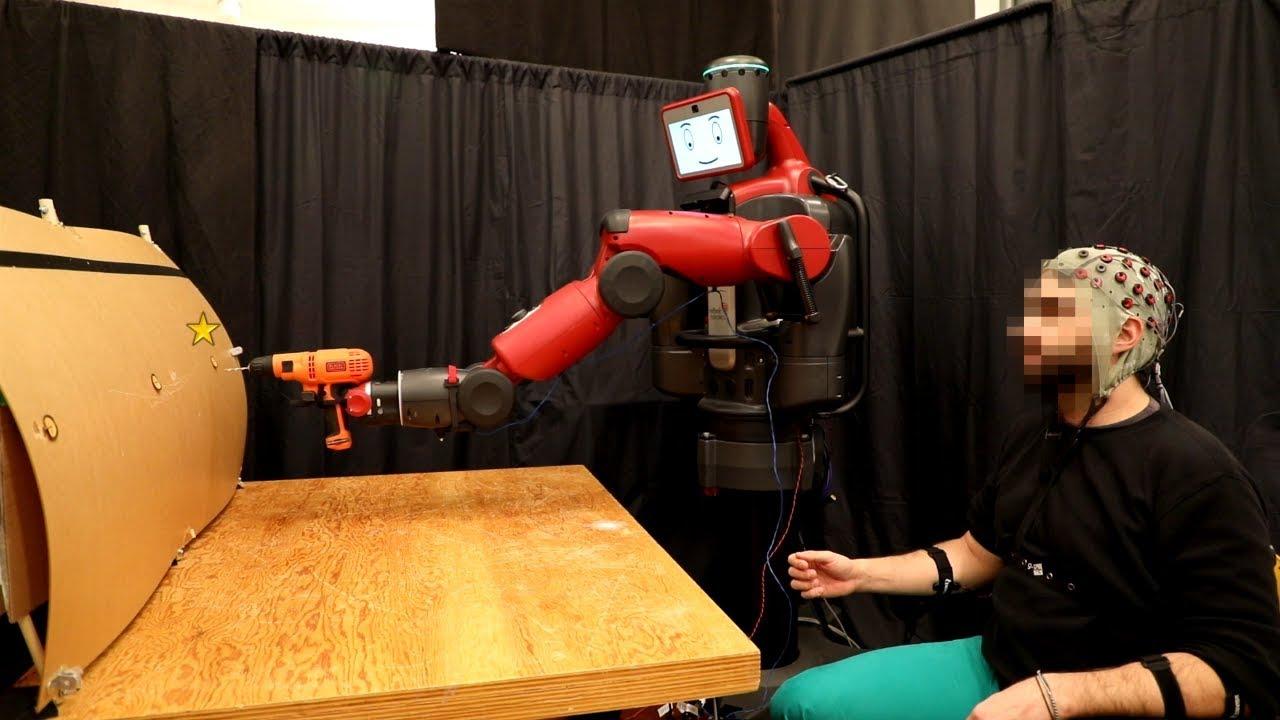

Además de las cámaras, están ganando peso los dispositivos wearables especializados para control gestual. Un ejemplo relevante es el trabajo de un equipo de la Universidad de California en San Diego (UCSD), que ha desarrollado un wearable capaz de transformar movimientos sutiles del cuerpo en órdenes fiables para robots y máquinas en entornos muy dinámicos.

Este dispositivo se coloca en la muñeca o se integra en la manga de una prenda y combina sensores flexibles basados en componentes químicos y nanotecnológicos con algoritmos de aprendizaje profundo que filtran el ruido en tiempo real. Así, incluso cuando el usuario se mueve con brusquedad o está rodeado de vibraciones, el sistema es capaz de extraer el gesto relevante y mantener un control estable.

La clave reside en que la IA se centra en separar los gestos intencionados del movimiento involuntario. Mientras una persona camina, corre o sube escaleras, el wearable elimina automáticamente esa “contaminación” de la señal y se queda solo con la información útil para manejar drones, robots submarinos, dispositivos domésticos o brazos robóticos.

La latencia es otro punto crítico en este tipo de soluciones: el equipo de UCSD ha conseguido que el sistema procese los datos sensoriales y genere la orden en menos de 100 milisegundos, algo esencial para aplicaciones en tiempo real como el pilotaje de robots móviles o la asistencia física a través de exoesqueletos.

Gracias a la gran precisión de sus sensores (capaces de detectar variaciones de orientación extremadamente pequeñas) y al enfoque de tolerancia al ruido, estos wearables pueden reconocer hasta unas 20 clases de gestos diferentes con tasas de acierto superiores al 95 %, incluso bajo vibraciones y movimientos bruscos típicos de entornos industriales o militares.

Control gestual en HMI: pantallas táctiles, industria y sanidad

En el ámbito de las interfaces hombre-máquina (HMI), el control gestual está cambiando la manera en la que operarios y usuarios se comunican con las máquinas. En muchos casos se combina con pantallas táctiles, pero aportando una capa extra de interacción sin contacto que hace la experiencia más natural y flexible.

En automoción, por ejemplo, cada vez más vehículos incorporan gestos para interactuar con el sistema de infoentretenimiento o ciertas funciones del habitáculo. Ajustar el volumen, aceptar una llamada, cambiar de pista o moverse por los menús puede hacerse con un simple gesto de la mano en el aire, lo que ayuda a que el conductor mantenga más la vista en la carretera y reduzca el tiempo de interacción con la pantalla.

En automatización industrial, las HMI con soporte de gestos permiten que un trabajador controle máquinas complejas con movimientos sencillos, sin necesidad de pulsar botones físicos o tocar paneles que puedan contaminarse. Esto es especialmente interesante en sectores como el alimentario o el farmacéutico, donde la higiene es fundamental.

Dentro del entorno sanitario, los gestos se utilizan para permitir interacción manos libres con equipos médicos. Un cirujano puede, por ejemplo, manipular imágenes radiológicas durante una intervención sin tocar la pantalla, reduciendo el riesgo de contaminación cruzada. También surgen aplicaciones en rehabilitación, donde los pacientes realizan gestos que el sistema evalúa para guiar ejercicios y monitorizar la recuperación de habilidades motoras.

Esta misma lógica se aplica a la electrónica de consumo: teléfonos, tablets, televisores y altavoces inteligentes incorporan funciones basadas en movimiento de manos para complementar el tacto y la voz. Deslizar, pellizcar, “tocar” en el aire o hacer un gesto de stop se convierten en acciones reconocibles para pausar contenido, avanzar, retroceder o cambiar de aplicación.

Robótica colaborativa y control gestual en la industria

En entornos de fabricación moderna los robots colaborativos (cobots) están diseñados para compartir espacio con personas sin vallas de seguridad. En este escenario, el control por gestos es una herramienta muy potente para que los operarios guíen al robot de manera intuitiva y a distancia, mejorando seguridad y ergonomía.

Un ejemplo práctico lo encontramos en soluciones donde se entrenan modelos de visión artificial para reconocer gestos simples como abrir la mano, cerrar el puño, señalar o hacer un pulgar hacia arriba o abajo. Cada uno de esos gestos se asocia a una orden: iniciar movimiento, parar, cambiar de dirección, confirmar una acción, etc.

Empresas como Siemens han demostrado sistemas de este tipo en centros de innovación como el Digital Experience Center de Barcelona. En su caso, el control gestual del robot se integra con controladores industriales avanzados (como SIMATIC S7-1500) y plataformas de visualización tipo WinCC Unified, de forma que el mismo concepto se puede adaptar a distintos modelos de brazo robótico.

El operario se coloca frente al robot colaborativo y, mediante gestos preentrenados, envía comandos que el controlador interpreta como órdenes de movimiento. El uso de machine learning y visión artificial en tiempo real garantiza que gestos muy comunes (abrir la palma, cerrar el puño, apuntar en una dirección) se lean correctamente aunque el entorno sea una feria, un taller con múltiples personas o una línea de producción con cierto desorden visual.

Este tipo de demostradores no solo ilustran las ventajas de seguridad (no hace falta tocar al robot ni acercarse a paneles de control), sino que también sirven para reducir la barrera de entrada: cualquier persona, incluso sin formación avanzada en programación, puede entender rápidamente cómo ordenar al robot lo que debe hacer.

Integración de voz, gestos y visión artificial en robots inteligentes

Más allá del gesto puro, algunos centros tecnológicos están trabajando en interfaces multimodales que combinan voz, gestos y visión artificial. Tekniker, por ejemplo, ha desarrollado soluciones basadas en deep learning sobre imágenes y procesamiento de lenguaje natural para facilitar aún más la convivencia entre personas y robots en entornos industriales.

En uno de sus demostradores, un robot colaborativo de bin picking se integra con una capa de software que permite al usuario elegir objetos mediante comandos de voz o gestos y especificar en qué zona deben colocarse. La visión artificial identifica qué piezas hay en el contenedor, qué elemento se va a coger a continuación y valida visualmente que la acción se está ejecutando de forma correcta.

En este tipo de soluciones el flujo es claro: el trabajador indica mediante un gesto o una frase el objeto deseado y la zona de depósito, la IA interpreta esa orden, el sistema de bin picking localiza la pieza apropiada con visión 3D y el cobot realiza la maniobra mientras la cámara supervisa la operación.

Detrás de estas interfaces “naturales” hay técnicas como machine learning, deep learning, modelos de detección de objetos, redes neuronales para reconocimiento de gestos y algoritmos de razonamiento sobre datos. Todo ello se integra para crear entornos colaborativos y digitalizados donde la interacción con el sistema automatizado resulta lo más parecida posible a tratar con otro operador humano.

La ventaja evidente es que el usuario no necesita programar ni conocer la lógica interna del robot: gestos y palabras se convierten en comandos de alto nivel que el sistema traduce a instrucciones técnicas, acercando la robótica avanzada a perfiles mucho más amplios dentro de la planta.

Control por gestos con sensores dedicados: el caso del PAJ7620

No todo pasa por complejos modelos de visión o wearables de investigación. Para proyectos educativos, makers o pequeños robots existe la opción de sensores específicos de reconocimiento de gestos como el PAJ7620, que se conectan al microcontrolador mediante I2C.

Este tipo de sensor suele traer ya un conjunto de gestos básicos predefinidos (mover la mano a la izquierda, derecha, arriba, abajo) y entrega al microcontrolador un código según el movimiento detectado. A partir de ahí, el programa interpreta ese código como una orden para el robot.

Un ejemplo típico es controlar un pequeño brazo robótico o una plataforma educativa: gesto hacia la izquierda, el robot gira en esa dirección; gesto hacia la derecha, gira hacia el otro lado; movimiento hacia arriba, el brazo sube; hacia abajo, baja. Con un único programa se puede reutilizar la lógica tanto en un robot educativo como en una placa orientada a proyectos STEAM (como microSTEAMakers).

Aunque esta aproximación es más sencilla que los sistemas basados en visión profunda, resulta perfecta para introducir el concepto de control de máquinas con gestos, prototipar ideas y enseñar a estudiantes cómo se traduce la interacción física en órdenes digitales de forma práctica y visual.

Además, estos sensores dedicados son relativamente económicos y facilitan que más personas puedan experimentar con interfaces sin contacto, ampliando el ecosistema de proyectos que se benefician del control gestual más allá de las grandes empresas o centros de investigación.

Ventajas, retos y futuro del control de máquinas con gestos

Entre las principales ventajas del control por gestos destaca su enorme capacidad para hacer la interacción más intuitiva y accesible. Realizar un gesto suele ser tan natural como manipular un objeto físico, lo que reduce la curva de aprendizaje y permite que gente con poca familiaridad tecnológica maneje sistemas complejos con relativa facilidad.

También aporta beneficios claros en seguridad e higiene. Al no tocar pantallas, botones ni mandos, se limita la propagación de gérmenes y se evita tener que acercarse a zonas potencialmente peligrosas de una máquina. Esto cobra sentido en quirófanos, líneas de producción de alimentos, laboratorios farmacéuticos o plantas donde el acceso físico a los controles puede ser arriesgado.

Otro aspecto clave es la eficiencia operativa y la posibilidad de trabajar a distancia. Un operador puede supervisar o ajustar máquinas desde cualquier punto de una sala simplemente estando dentro del campo de visión de la cámara o del sensor. En entornos con varios robots, es posible imaginar escenarios en los que varios usuarios utilizan gestos para dirigir distintos equipos de forma simultánea sin que haya interferencias.

No obstante, la tecnología no está exenta de desafíos. Factores como la iluminación deficiente, sombras fuertes, reflejos o cámaras de baja calidad pueden alterar seriamente el rendimiento de los sistemas basados en visión. Del mismo modo, la variabilidad natural en la forma de hacer un gesto (tamaño de manos, ángulo, velocidad, presencia de guantes o accesorios) introduce incertidumbre.

Algunos modelos también sufren cuando los movimientos son demasiado rápidos, provocando desenfoque de movimiento o pérdida de fotogramas clave. Para minimizar estos problemas, se recurre a sensores de mejor calidad, tasas de refresco más altas, algoritmos de compensación de movimiento y, en el caso de los wearables avanzados, a técnicas de filtrado del ruido basadas en deep learning.

Mirando hacia adelante, todo apunta a que la combinación de mejores sensores, modelos de IA más robustos y mayor potencia de cálculo en el borde hará que construir interfaces sin contacto sea cada vez más sencillo. Veremos más control gestual integrado en coches, hogares, fábricas, hospitales, videojuegos y experiencias de realidad aumentada y virtual, con catálogos de gestos más ricos y personalizables.

El ecosistema de tecnologías para controlar máquinas con gestos —desde sensores I2C sencillos hasta wearables de precisión, pasando por cámaras 3D y complejas HMI industriales— está convergiendo hacia un mismo objetivo: que relacionarnos con robots y dispositivos sea tan natural como hablar o mover las manos. A medida que se pulen los retos de precisión, aceptación de usuario e integración con sistemas existentes, el control gestual se consolida como una pieza central en la evolución de la interacción hombre-máquina.