La llegada de la Raspberry Pi AI HAT+ 2 supone un nuevo paso para quienes quieren trabajar con inteligencia artificial directamente en una Raspberry Pi 5 sin depender de la nube. Esta placa de expansión combina un acelerador neuronal dedicado y memoria propia para descargar gran parte del trabajo de IA del procesador principal y permitir usos más ambiciosos en el terreno de la IA generativa.

Con un precio recomendado de alrededor de 130 dólares (el importe final en España y en el resto de Europa dependerá de los distribuidores oficiales), la AI HAT+ 2 se posiciona como una opción relativamente asequible para experimentar con modelos de lenguaje y visión artificial en el borde. No es un sustituto de soluciones de gama alta, pero sí una pieza llamativa para proyectos de IoT, automatización, prototipado y formación.

Qué es exactamente la Raspberry Pi AI HAT+ 2

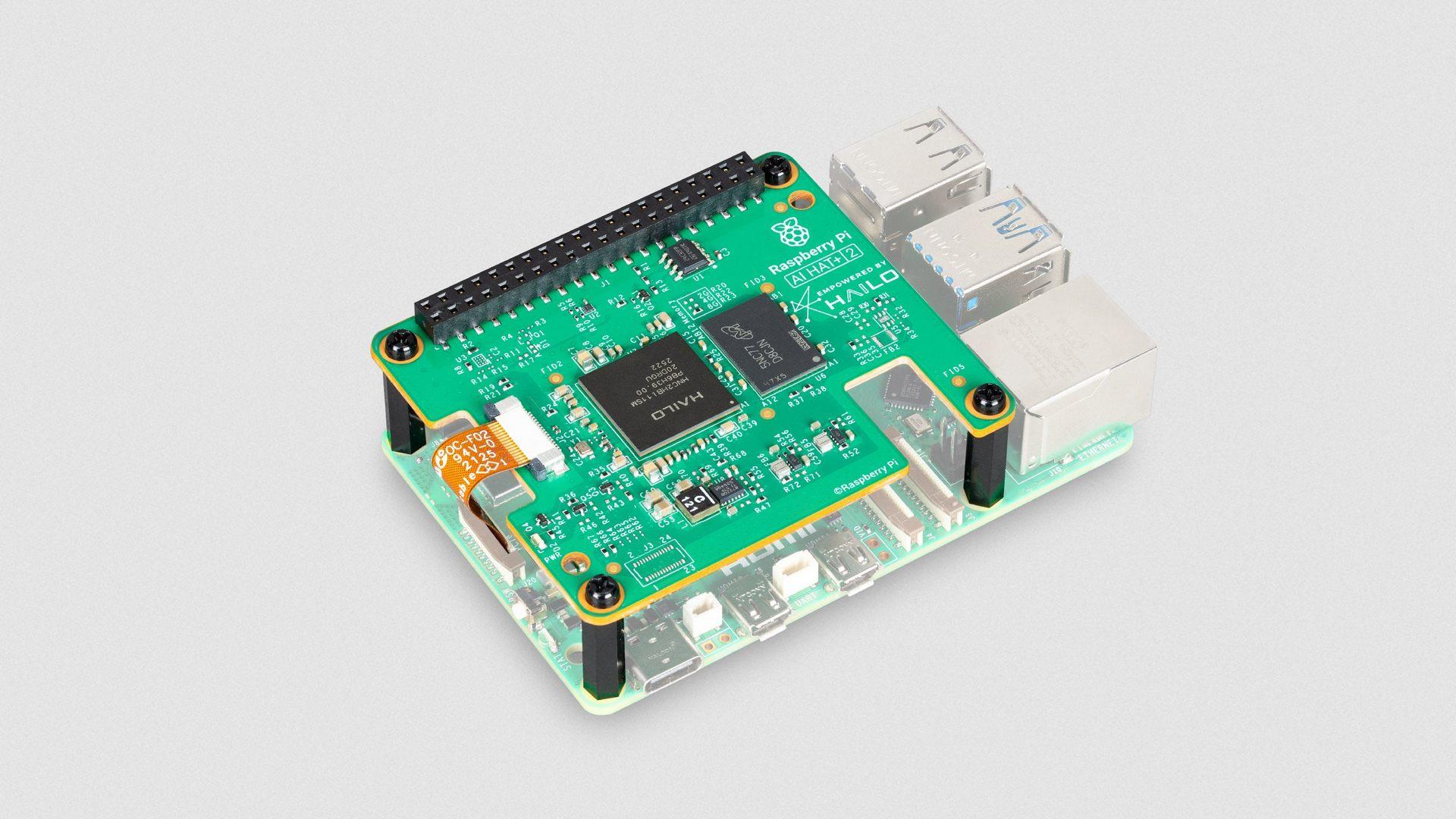

La Raspberry Pi AI HAT+ 2 es una placa de ampliación para la Raspberry Pi 5 que se conecta mediante la interfaz PCI Express integrada en la propia placa base. Nace como sucesora directa de la primera AI HAT+, lanzada en 2024, que se centraba casi por completo en tareas de visión por computador gracias a los aceleradores Hailo‑8 y Hailo‑8L.

En este nuevo modelo, Raspberry Pi Holdings plc apuesta por el acelerador de redes neuronales Hailo‑10H y añade 8 GB de memoria LPDDR4X dedicados en la propia tarjeta. Esta combinación se orienta a soportar cargas de trabajo de IA generativa, especialmente modelos de lenguaje grandes de tamaño reducido y modelos de visión‑lenguaje, directamente en el dispositivo.

Al disponer de memoria DRAM en el propio HAT, el sistema puede separar los recursos de la Raspberry Pi 5 (CPU, GPU y RAM principal) de los del acelerador de IA. Esto permite que la placa principal se encargue de la lógica de la aplicación, comunicaciones o interfaz de usuario, mientras el coprocesador Hailo‑10H asume gran parte de la inferencia.

Hardware, rendimiento y diferencias con la primera AI HAT+

El corazón del nuevo accesorio es el Hailo‑10H NPU, un acelerador especializado en redes neuronales que, según los datos de Raspberry Pi y Hailo, ofrece hasta 40 TOPS de rendimiento de inferencia. En la documentación se habla de cifras en INT4 e INT8, lo que indica que parte del rendimiento máximo se logra con cuantización agresiva, muy habitual en despliegues de IA en el borde. Aunque otras plataformas embebidas como la Nvidia Jetson T5000 ofrecen alternativas con distinta arquitectura.

El consumo del Hailo‑10H está limitado a unos 3 W, lo que ayuda a mantener el conjunto dentro de márgenes razonables de temperatura y potencia, algo clave en proyectos embebidos y en cajas compactas. A cambio, esta restricción implica que el rendimiento bruto no siempre superará al de la propia Raspberry Pi 5 trabajando sola en determinadas tareas, especialmente si se comparan cargas muy optimizadas para la CPU y la GPU integradas.

Frente al primer AI HAT+, la mejora principal está en el salto desde los 13/26 TOPS del Hailo‑8L y Hailo‑8 a los 40 TOPS, además de la aparición de los 8 GB de RAM a bordo. El modelo original estaba más pensado para detección de objetos, estimación de poses o segmentación, mientras que esta segunda generación abre la puerta a LLMs y modelos multimodales, manteniendo las capacidades de visión.

Raspberry Pi ha recalcado que la integración con el entorno de cámara debería ser prácticamente transparente para los proyectos existentes, ya que la integración con el stack de software de la compañía se mantiene, evitando tener que reescribir desde cero todo el código de visión por computador.

Modelos de IA compatibles y uso de LLM en local

Uno de los puntos que más llama la atención es la posibilidad de ejecutar modelos de lenguaje en local sobre la Raspberry Pi 5, apoyándose en la potencia de la NPU y la memoria dedicada del HAT. Durante el lanzamiento, la compañía ha mencionado una serie de LLMs entre 1.000 y 1.500 millones de parámetros como configuración de partida.

Entre los modelos citados se encuentran DeepSeek‑R1‑Distill, Llama 3.2, Qwen2, Qwen2.5‑Instruct y Qwen2.5‑Coder. Estos modelos relativamente compactos permiten casos de uso como chat básico, generación de código, traducción de textos o descripción de escenas, todo ello sin enviar los datos a servidores externos.

La placa está pensada para aprovechar técnicas de cuantización e inferencia optimizada, de forma que modelos de este tamaño puedan ejecutarse con baja latencia y manteniendo un consumo ajustado. Raspberry Pi y Hailo han mostrado ejemplos de traducción entre idiomas y respuestas a preguntas simples ejecutadas completamente en el dispositivo.

Eso sí, conviene tener claro que la AI HAT+ 2 no está diseñada para modelos masivos como las versiones completas de ChatGPT, Claude o los LLM de mayor tamaño de Meta, cuyo número de parámetros se mueve en rangos de cientos de miles de millones o incluso billones. En esos casos, la barrera no solo es la potencia de cómputo, sino sobre todo la memoria necesaria.

Limitaciones de memoria y comparación con una Raspberry Pi 5 de 16 GB

Aunque los 8 GB de RAM LPDDR4X dedicados suponen una mejora importante respecto a la primera generación de AI HAT+, esa cifra tiene implicaciones claras. Muchos modelos de lenguaje cuantizados de tamaño medio y con contextos amplios pueden requerir fácilmente más de 10 GB de memoria, por lo que, de momento, el accesorio se orienta a modelos más pequeños o con contextos recortados.

Si se compara directamente con una Raspberry Pi 5 de 16 GB, la placa base con la mayor configuración de memoria sigue ofreciendo más margen para cargar modelos grandes íntegramente en RAM, sobre todo si se renuncia a una parte de la memoria para otras tareas y se dedica el sistema casi en exclusiva a la IA.

En la práctica, la combinación de una Pi 5 y el AI HAT+ 2 tiene sentido cuando se quiere separar las funciones: dejar que el Hailo‑10H se encargue de la inferencia y que la placa principal mantenga un escritorio ligero, servidores web, lógica de automatización o servicios adicionales. De esta manera, el sistema puede seguir siendo usable mientras se ejecutan modelos de lenguaje o de visión.

Para quienes solo quieran chatear con una IA local sencilla, traducir textos o probar asistentes básicos, el equilibrio entre potencia, consumo y coste del AI HAT+ 2 puede resultar suficiente. Sin embargo, para la memoria necesaria por modelos de gran tamaño o para contextos muy extensos, seguirá siendo más práctico recurrir a equipos con más memoria o a la nube.

Visión por computador y ejecución simultánea de modelos

Una de las ventajas de esta nueva generación es que no se renuncian a las capacidades de visión por computador que ya ofrecía el primer AI HAT+. El Hailo‑10H mantiene un rendimiento muy similar al Hailo‑8 a la hora de ejecutar modelos de detección y seguimiento de objetos, estimación de postura humana o segmentación de escenas.

Raspberry Pi indica que la AI HAT+ 2 es capaz de ejecutar de forma simultánea modelos de visión y de lenguaje, lo cual la hace interesante para proyectos que combinen cámaras y texto: por ejemplo, cámaras inteligentes que generen descripciones, sistemas de vigilancia que clasifiquen eventos o dispositivos que ofrezcan resúmenes de lo que ocurre en una escena.

En el terreno práctico, se mencionan escenarios como el uso de modelos tipo YOLO para detección de objetos en tiempo real, con tasas de refresco que pueden rondar los 30 fotogramas por segundo según la complejidad del modelo y la resolución. La idea es que el HAT asuma esa carga mientras la Raspberry Pi 5 maneja el almacenamiento, la interfaz o el envío de alertas.

El ecosistema de software todavía está en proceso de maduración: aunque hay ejemplos y frameworks oficiales, la ejecución en paralelo de varios modelos (visión, lenguaje, multimodal) sigue siendo un campo en evolución. En cualquier caso, la integración con la pila de cámaras de Raspberry Pi simplifica bastante la puesta en marcha para quienes ya trabajaban con módulos de cámara oficiales.

Casos de uso en España y Europa: IoT, industria y prototipos

La combinación de bajo consumo, tamaño reducido y ejecución local de la IA encaja bien con muchas de las tendencias de digitalización que se están viendo en España y en otros países europeos. En entornos industriales, donde el acceso constante a la nube no siempre está garantizado o no es deseable por motivos de confidencialidad, una solución de este tipo frente a alternativas como la integración de Nvidia en chips puede ser especialmente útil.

Entre los usos que más se repiten en la documentación se encuentran aplicaciones de automatización industrial, control de procesos y gestión de instalaciones. Sistemas de inspección visual en líneas de producción, detección de anomalías en tiempo real, supervisión de accesos o recuento de personas son algunos de los casos que podrían beneficiarse de combinar visión y modelos de lenguaje ligeros.

En el terreno del IoT doméstico y comercial, la AI HAT+ 2 puede servir como base para asistentes locales, paneles inteligentes que interpreten datos de sensores, cámaras que describan escenas o dispositivos de análisis de vídeo que no tengan que subir imágenes a servidores externos, lo que ayuda a cumplir normativas de privacidad cada vez más exigentes en la Unión Europea.

También es una opción a considerar como kit de desarrollo para empresas y startups que valoren integrar el chip Hailo‑10H en sus propios productos finales. Probar la solución en una Raspberry Pi 5 permite validar rendimiento, consumo y estabilidad antes de embarcarse en diseños de hardware a medida.

Perfil de usuario: desde makers hasta desarrolladores profesionales

La AI HAT+ 2 se dirige a varios perfiles a la vez. Por un lado, a la comunidad de makers y entusiastas que ya están familiarizados con las Raspberry Pi y quieren ir un paso más allá con proyectos de IA generativa o visión avanzada sin invertir en estaciones de trabajo específicas o en tarifas cloud continuas.

Por otro, apunta claramente a desarrolladores profesionales y startups que busquen un entorno de pruebas asequible para IA embebida. Frente a soluciones con GPUs discretas o NPUs para PC industrial, este HAT ofrece un formato compacto, un consumo ajustado y un coste más contenido, a costa de renunciar a los niveles de potencia de plataformas mucho más caras.

En entornos educativos y de formación técnica en España y Europa puede convertirse en una herramienta útil para acercar la formación técnica a la práctica, permitiendo que el alumnado experimente con modelos reales en hardware relativamente económico.

Eso sí, para usuarios que solo quieran ejecutar modelos de lenguaje en local con el máximo margen posible, una Raspberry Pi 5 con 16 GB de RAM sin HAT puede seguir siendo una opción más sencilla, siempre que se acepte que la CPU y la GPU de la placa principal serán las que soporten toda la inferencia.

Integración de software y recursos para empezar

Raspberry Pi ha hecho hincapié en que la AI HAT+ 2 interfaz PCIe y el entorno habitual de la Raspberry Pi 5, reduciendo la fricción para quienes ya conocen el ecosistema. La comunicación con el HAT se realiza a través de la interfaz PCIe, y los controladores y librerías específicos permiten dirigir las cargas de trabajo de IA hacia el Hailo‑10H.

Por parte de Hailo, los usuarios disponen de un repositorio en GitHub y una Developer Zone donde se ofrecen ejemplos de código, modelos preconfigurados, tutoriales y frameworks para sacar partido tanto a la IA generativa como a la visión computarizada. Esto facilita empezar con prototipos sin necesidad de construir toda la pila desde cero.

En el momento del lanzamiento ya se anuncian varios modelos de lenguaje listos para instalar, con la promesa de ir ampliando el catálogo con variantes más grandes o afinadas a casos de uso específicos. Además, se menciona la posibilidad de recurrir a técnicas como LoRA (Low‑Rank Adaptation) para adaptar los modelos a tareas concretas sin tener que reentrenarlos por completo.

Como suele ocurrir en este tipo de soluciones, la experiencia real dependerá del grado de madurez del software. Algunos analistas señalan que todavía hay margen de mejora en estabilidad, herramientas y soporte para ejecuciones simultáneas de varios modelos, pero la tendencia apunta a una integración cada vez más pulida dentro del ecosistema Raspberry Pi.

Precio, disponibilidad y aspectos prácticos

En cuanto al precio, la Raspberry Pi AI HAT+ 2 se ha anunciado con un coste de referencia de 130 dólares. En España y en otros países europeos, el importe final dependerá del tipo de cambio, los impuestos y la política de cada distribuidor, por lo que es previsible encontrar ligeras variaciones.

La placa es compatible con todas las versiones de Raspberry Pi 5, desde los modelos con 1 GB hasta los de 16 GB de RAM, y se conecta mediante la interfaz PCIe del propio SBC. Esto evita recurrir a adaptadores adicionales y simplifica el montaje en cajas o chasis pensados para el formato estándar.

En el paquete se incluye un disipador opcional para el Hailo‑10H. Aunque la NPU está limitada a unos 3 W, la recomendación habitual es instalar ese disipador, sobre todo si se van a ejecutar cargas de trabajo intensivas durante largos periodos o benchmarks exigentes, ya que el chip puede alcanzar temperaturas elevadas.

En el momento de la presentación, algunas tiendas especializadas informaban de stock limitado, algo habitual cada vez que aparece un nuevo accesorio popular de Raspberry Pi. Por ello, quienes quieran asegurarse una unidad en el corto plazo tendrán que estar atentos a la disponibilidad en distribuidores europeos autorizados.

La Raspberry Pi AI HAT+ 2 se posiciona como una solución intermedia entre la nube y los grandes servidores de IA, pensada para quienes necesitan procesamiento local, privacidad de datos y costes contenidos. Ofrece una forma relativamente accesible de combinar visión por computador y modelos de lenguaje ligeros en el borde, con margen para crecer a medida que el software madure y se enriquezca el catálogo de modelos disponibles, siempre que se asuman las limitaciones de potencia y memoria propias de un dispositivo diseñado para el bajo consumo.