La nueva familia de núcleos Arm C1 marca un cambio importante en el ecosistema móvil y de dispositivos ultraportátiles, sustituyendo a los conocidos Cortex con un enfoque más claro en rendimiento sostenido y eficiencia. Esta generación llega con la plataforma Lumex y con un objetivo evidente: acelerar la IA en el propio dispositivo sin comprometer batería ni temperatura.

Más allá del cambio de nombre, la propuesta combina arquitectura Armv9.3-A, un rediseño profundo del subsistema de memoria y un impulso relevante a las capacidades de computación matricial. El resultado se traduce en mejoras generalizadas de rendimiento con un consumo más contenido, además de una hoja de ruta pensada para smartphones, tablets, portátiles y wearables.

Arquitectura y novedades de los núcleos Arm C1

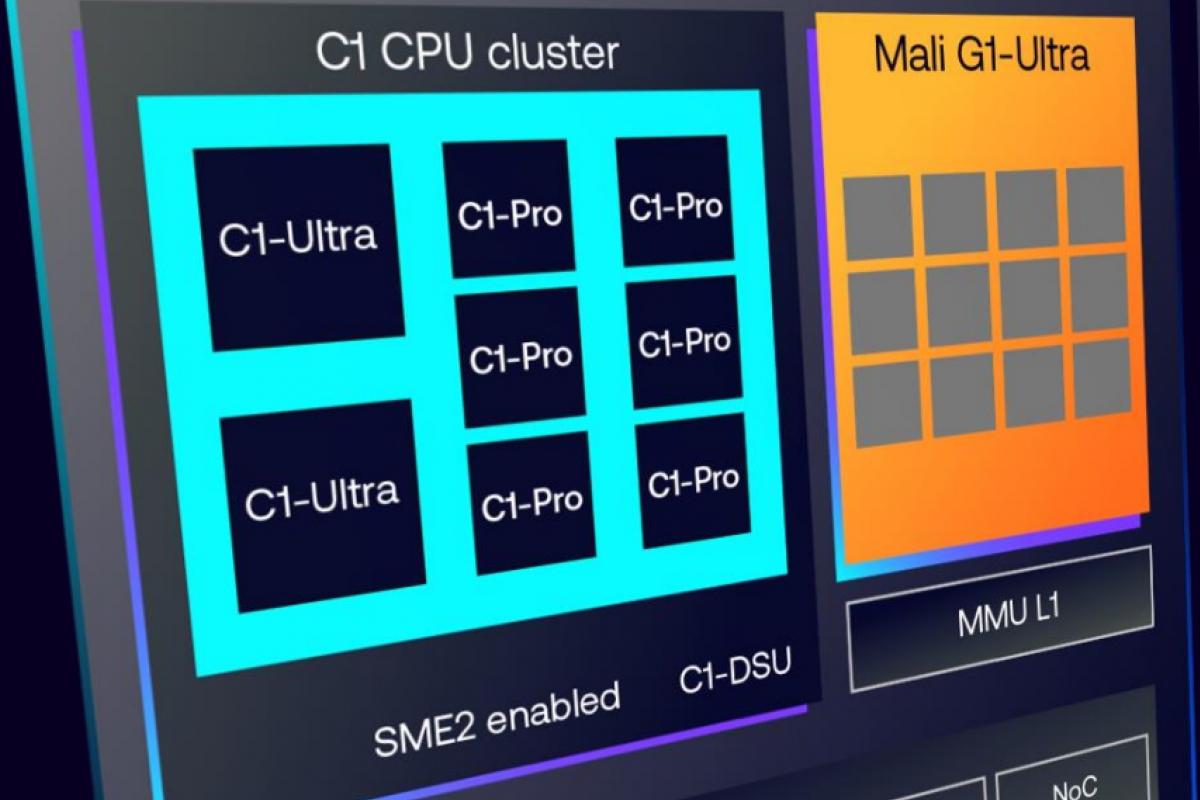

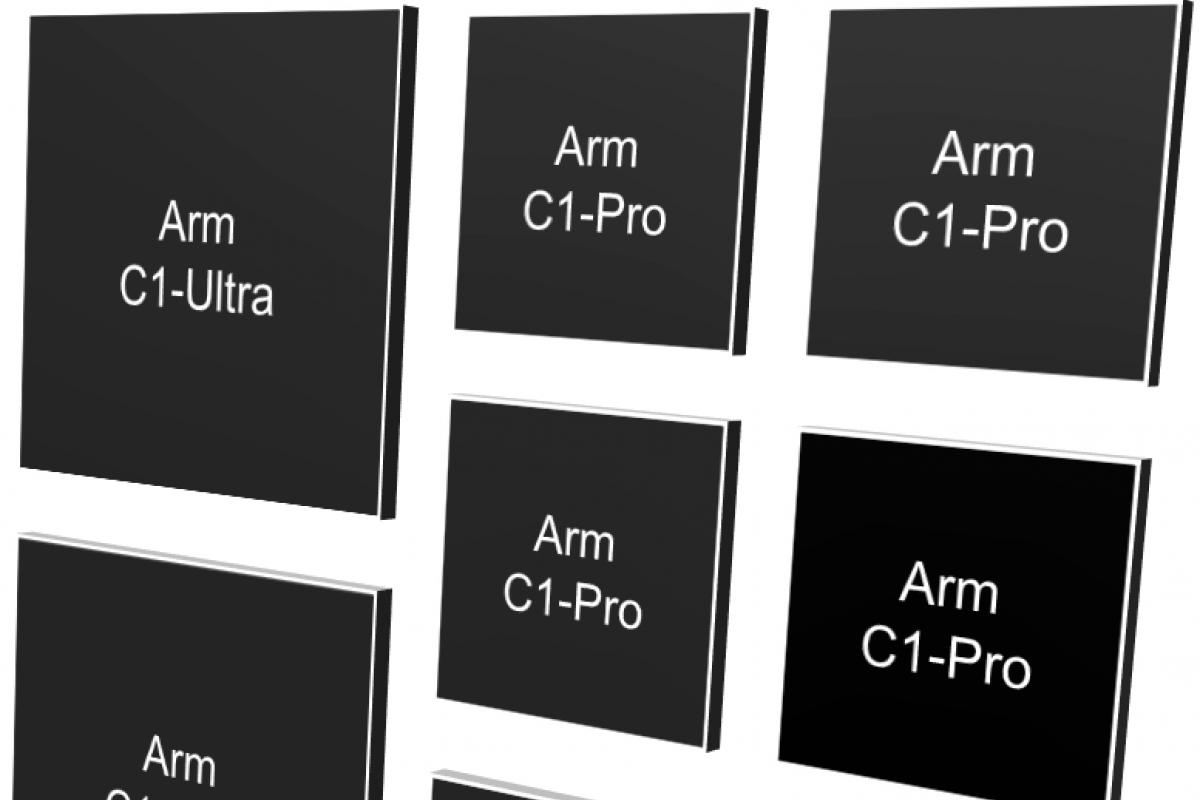

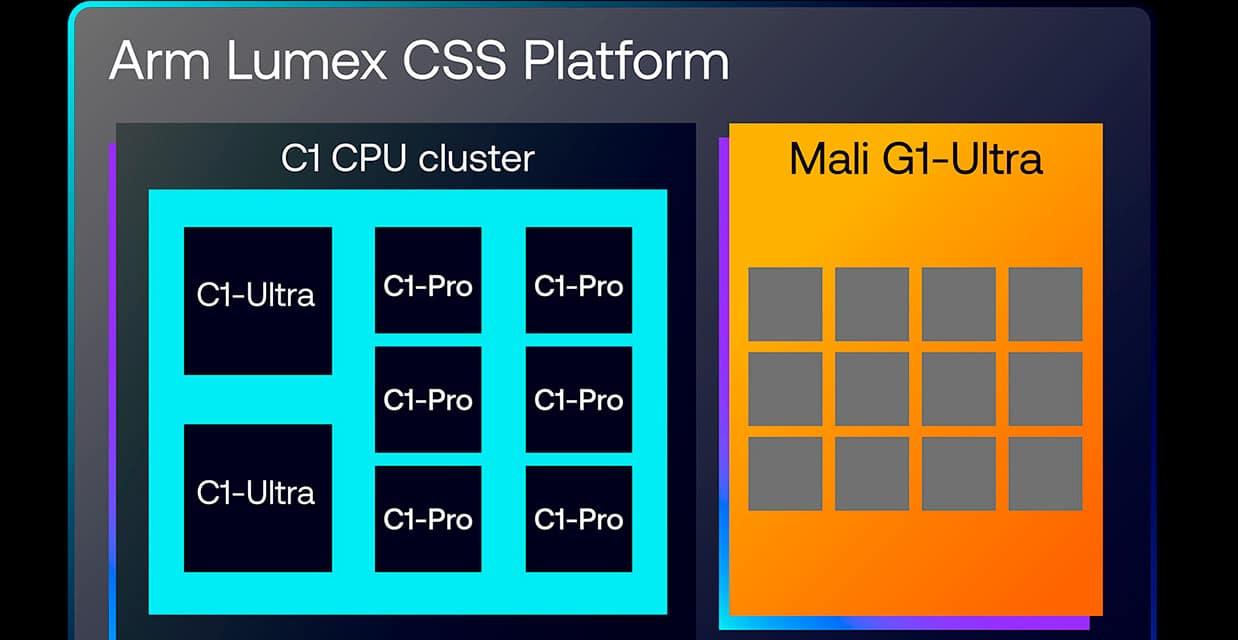

La serie C1 se organiza en cuatro variantes: C1-Ultra (máximo rendimiento), C1-Premium (alto rendimiento en menos área), C1-Pro (equilibrio) y C1-Nano (máxima eficiencia). Cada fabricante puede combinar estos bloques en clústeres heterogéneos para crear SoC adaptados a diferentes gamas y usos, con configuraciones de hasta 14 núcleos.

Arm ha retocado tanto el front‑end como el back‑end, incluyendo mejoras de predicción, cachés y ejecución fuera de orden. Gracias a la nueva interconexión y a una caché compartida más eficiente (con uso intensivo de celdas SLC), la plataforma ofrece incrementos medios cercanos al 15% en usos cotidianos, que escalan a +30% en cargas exigentes y alcanzan picos de hasta un 45% en multinúcleo.

El soporte de memoria evoluciona con LPDDR6 para reducir consumo y latencias, manteniéndose la compatibilidad con LPDDR5X a velocidades de hasta 9600 MT/s. Esta base de memoria, junto al rediseño del clúster, refuerza el rendimiento sostenido y la respuesta bajo presión térmica.

C1-Ultra: el techo de rendimiento

Como núcleo tope de gama, C1-Ultra apunta a los SoC insignia y a tareas de alta demanda como fotografía computacional, modelos grandes de IA o juegos AAA móviles. Frente al Cortex‑X925, Arm habla de un +25% en monohilo, cifra que ayuda a escalar el rendimiento global cuando se combina con más núcleos en el clúster.

El front‑end mejora el ancho de banda de L1 de instrucciones y la precisión de predicción, mientras que el back‑end incrementa la ventana de ejecución fuera de orden en torno a un 25%, llegando a manejar unas 2.000 instrucciones simultáneamente. Además, se duplica la L1 de datos hasta 128 KB y se acelera la lectura de L1 en aproximadamente un 33%.

C1-Premium: alto rendimiento en menos área

Para dispositivos premium que no necesiten el máximo absoluto, C1-Premium mantiene una arquitectura muy cercana a Ultra pero con una reducción de área del 35%. Está pensado para equilibrar prestaciones y coste, facilitando diseños más compactos sin renunciar a cifras notables.

C1-Pro: equilibrio y músculo multinúcleo

En el segmento central, C1-Pro sustituye a los Cortex‑A725 con un +11% de rendimiento a igual consumo y con mejoras de eficiencia que alcanzan hasta un 26% menos de energía al mismo rendimiento. En juegos, Arm cita ganancias de alrededor de +16% en esta clase de núcleos.

Las claves están en un front‑end más capaz (predicción estática refinada y un BTB mucho mayor), y en un back‑end con más ancho de banda en L1D y menor latencia en L2 cuando la predicción acierta. También se ha ajustado el predictor para acelerar la respuesta en escenarios reales.

C1-Nano: eficiencia por encima de todo

Para tareas ligeras y ahorro extremo, C1-Nano incrementa la eficiencia en torno a un 26% frente a su predecesor (manteniendo el área prácticamente intacta, ~+2% sobre A520). Se han desacoplado etapas de predicción y búsqueda para traer antes las instrucciones a L1 y recortar esperas por predicciones fallidas.

Además, se optimiza el procesamiento vectorial, se apagan unidades cuando el pipeline se atasca y se reduce el tráfico entre L3 y DRAM (alrededor de un 21% de media y hasta un 39% en ciertas cargas), lo que alivia consumo y mejora la respuesta.

C1-DSU: clústeres flexibles y menos consumo

El nuevo C1‑DSU orquesta la conexión de los núcleos bajo una caché L3 compartida y hace de puente con el resto del SoC (RAM, GPU, etc.). Frente a iteraciones previas, el diseño rebaja el consumo típico del sistema en torno a un 11% y el impacto de la memoria en un ~7%, apoyándose en modos como L3 Quick Nap para minimizar pérdidas cuando no se usa.

Otra pieza clave es la integración de los aceleradores SME2 como elementos externos al núcleo: en C1‑Ultra y C1‑Premium su presencia es obligatoria, mientras que en C1‑Pro y C1‑Nano es opcional según el diseño del fabricante. Cualquier núcleo del clúster puede acceder a ellos cuando están presentes, lo que habilita combinaciones muy diversas (por ejemplo, 2× C1‑Ultra + 6× C1‑Pro con uno o dos aceleradores SME2, o conjuntos más modestos mezclando Pro y Nano).

La plataforma Lumex contempla también GPU de nueva hornada. Aunque el foco de esta noticia son las CPU, la Mali G1 acompaña con mejoras de ~20% en rendimiento gráfico, dobla el throughput de ray tracing y reduce el coste energético por fotograma alrededor de un 9%, reforzando el conjunto para juegos y cargas de IA que prefieran la GPU.

SME2 y el papel de la CPU en la IA

El gran salto en IA llega con SME2 (Scalable Matrix Extension 2), que acelera multiplicaciones matriciales, predicados múltiples y nuevos tipos de datos (incluidas precisiones compactas como 2b/4b), y se coordina con SVE2 para vectorización avanzada. En números agregados, Arm habla de mejoras medias de 3,7x con descensos de consumo cercanos a un 27%.

En casos prácticos, la compañía ha mostrado reducciones de latencia de 4,7x en reconocimiento de voz (Whisper Base), aceleraciones de 2,4–2,8x en texto a voz y grandes incrementos en generación de tokens para LLM (por ejemplo, Gemma 3) que rozan el ×5. Al ejecutar en CPU se evitan transferencias a otros aceleradores, lo que recorta esperar y aporta reactividad.

Para cargas pequeñas o interactivas, la CPU vuelve a ser protagonista: con SME2, muchas tareas cotidianas (mejora de imagen local, segmentación, clasificación, efectos de cámara o audio) se completan antes, gastando menos y sin pasar por la red. Cuando la demanda crece, la GPU o una NPU externa pueden seguir tomando el relevo, pero la CPU ya no es un cuello de botella.

El soporte software también acompaña: hay integración en Linux y Android 16, toolchains y librerías optimizadas (KleidiAI), y compatibilidad en motores como Unity y Unreal Engine. Esto facilitará que apps y juegos adopten estas mejoras con rapidez a medida que lleguen los primeros SoC comerciales.

La plataforma Lumex CSS pone todas las piezas juntas (CPU C1, GPU Mali G1, interconexión y memoria) con diseños listos para producción a 3 nm, telemetría en hardware y compatibilidad de sistemas Arm con LPDDR6. Así, los socios pueden acelerar sus proyectos para móviles y portátiles, con clústeres escalables de hasta 14 núcleos y opciones de IA en el propio dispositivo.

Los Arm C1 combinan rendimiento sostenido, eficiencia y un empuje real a la IA en CPU gracias a SME2; ofrecen la flexibilidad de C1‑DSU para adaptar los clústeres a cada gama de producto y constituyen una base sólida para la próxima hornada de SoC móviles y portátiles que busca equilibrar potencia, autonomía y capacidades de IA sin depender siempre de la nube.