La computación cuántica ha dejado de ser ciencia ficción para convertirse en un motor de cambio con efectos reales en la informática, la economía y, en general, en nuestra vida digital. No veremos un procesador cuántico sustituyendo al CPU del portátil del salón, pero el acceso remoto a su potencia ya está marcando el paso en ámbitos como la privacidad, las finanzas, la salud, el transporte o el entretenimiento.

Junto a las oportunidades llegan riesgos considerables: la posibilidad de que futuros equipos cuánticos rompan los cifrados más usados hoy ha encendido todas las alarmas. Esa tensión entre promesa e incertidumbre —a la que muchos se refieren como «apocalipsis cuántico»— obliga a empresas y organismos a prepararse para la era poscuántica con nuevas normas, herramientas y estrategias de seguridad.

Nota de contexto: última actualización de parte del material sectorial consultado en agosto de 2023; la estandarización oficial de PQC continuó en 2024.

Qué es un procesador cuántico y por qué no reemplazará al ordenador clásico

Un procesador cuántico (QPU) manipula información mediante cúbits, que explotan fenómenos como la superposición y el entrelazamiento. A diferencia de los bits clásicos, los cúbits permiten representar y procesar ciertos problemas de forma radicalmente distinta, lo que abre la puerta a ventajas abrumadoras en tareas específicas (optimización, simulación de materiales o química, factorización, etc.).

Eso no significa que «haga todo más rápido». En la práctica, los QPU se usan como aceleradores cuánticos acoplados a ordenadores tradicionales: el sistema clásico prepara los datos y el circuito, envía la tarea a la QPU y, tras medir, interpreta los resultados. Este enfoque híbrido es el que veremos extenderse a través de la nube, con modelos de QaaS (Quantum as a Service).

Operativamente, un sistema cuántico actual parece un «candelabro» tecnológicamente sofisticado: refrigeración criogénica cercana al cero absoluto, aislamiento extremo y electrónica de control que traduce instrucciones en microondas para manipular los estados de los cúbits. Esta infraestructura explica su coste y que, de momento, no sea viable tener uno en casa.

Conviene remarcarlo con claridad: la computación cuántica no sustituye a la clásica; la complementa. Donde un algoritmo cuántico cambia la estructura de un problema, puede lograr aceleraciones notables; donde no hay esa reformulación, los ordenadores clásicos seguirán siendo la opción más eficiente.

Impacto por sectores: de la salud a la logística

Sanidad. El gran salto está en modelar la materia a nivel cuántico. Simular con fidelidad moléculas y reacciones permite acelerar el descubrimiento de fármacos y vacunas, personalizar terapias y mejorar diagnósticos. Crear y probar moléculas en laboratorio es lento; con QPU, los investigadores podrán explorar espacios químicos gigantescos virtualmente antes de sintetizar, recortando tiempos de I+D.

Finanzas. La industria financiera puede ser de las primeras en notar beneficios prácticos: desde la optimización de carteras hasta la valoración de derivados complejos y la detección de anomalías, los algoritmos cuánticos y cuántico-inspirados ayudan a evaluar riesgos en escenarios altamente combinatorios. Esto no implica adivinar el mercado, pero sí mejorar la toma de decisiones en entornos de incertidumbre.

Meteorología y clima. Modelar la atmósfera a alta resolución es tan costoso que a veces un superordenador tarda más en predecir de lo que el tiempo tarda en cambiar. Con técnicas cuánticas, los modelos podrían refinarse y actualizarse más deprisa, con efectos en sectores como transporte o agricultura. Se estima que casi un 30% del PIB de EE. UU. está influido directa o indirectamente por el tiempo.

Transporte, viajes y logística. La combinación de IA y QPU puede optimizar rutas, gestión del tráfico aéreo y señalización urbana a una escala difícil hoy. En escenarios logísticos complejos, grandes operadores han estimado mejoras de eficiencia con potencial para multiplicar beneficios muy significativamente; se han citado incrementos teóricos de hasta un 600% en ciertos supuestos de última milla y distribución.

Medios, entretenimiento, seguros y gran consumo. Más allá de los casos estrella, veremos impactos en sistemas de recomendación, tarificación dinámica o simulaciones de riesgo, al tiempo que se abren nuevos modelos de negocio impulsados por capacidades de cálculo antes inalcanzables.

Riesgos de seguridad: el «apocalipsis cuántico» y la urgencia de la agilidad criptográfica

El temor más inmediato es que la computación cuántica haga vulnerables RSA y ECC, pilares del cifrado moderno. El algoritmo de Shor muestra cómo, con suficiente escala y calidad, una QPU podría factorizar enteros grandes y calcular logaritmos discretos de forma eficiente, dejando obsoletos mecanismos de confianza muy extendidos.

A esto se suma la estrategia «almacenar ahora, descifrar después» (SNDL): atacantes que capturan hoy datos cifrados con la esperanza de romperlos cuando cuenten con recursos cuánticos adecuados. La ventana de riesgo es real para la información con larga vida útil (sanitaria, financiera, gubernamental).

La cadena de bloques no es inmune. Mecanismos de consenso como PoW y PoS, así como los esquemas de firma utilizados por muchas criptomonedas, podrían verse presionados por ataques cuánticos avanzados. La percepción de invulnerabilidad nunca fue absoluta y la transición a soluciones poscuánticas será clave para preservar la integridad.

Todo esto exige agilidad criptográfica: capacidad para migrar con rapidez a algoritmos resistentes a la cuántica, actualizar certificados, protocolos y hardware, y gestionar coexistencias sin romper servicios. No es un cambio puntual, sino un proceso continuo y gobernado a nivel de arquitectura.

Prepararse hoy: PQC estandarizada, QKD, MPC y colaboración global

Las buenas noticias: ya disponemos de una base sólida para la transición. El NIST ha seleccionado algoritmos poscuánticos y en 2024 publicó las primeras FIPS PQC —FIPS-203, FIPS-204 y FIPS-205—, un hito decisivo para que la industria alinee implementaciones y políticas de ciclo de vida. Esta estandarización se apoya en una década de investigación abierta y pruebas de interoperabilidad.

En paralelo, comunidades técnicas impulsan hackatones del IETF para validar protocolos poscuánticos y su integración en ecosistemas reales. Muchas organizaciones trabajan con modelos de madurez PQC que mapean activos, riesgos y rutas de migración, ayudando a priorizar dominios críticos (identidades, TLS, firmware, IoT) y a desplegar pilotos controlados.

Junto a la PQC basada en problemas matemáticos (por ejemplo, celosías), ganan tracción enfoques físicos como la distribución cuántica de claves (QKD), especialmente en redes de alta sensibilidad. La investigación en repetidores cuánticos apunta a ampliar la distancia efectiva de estas soluciones, con arquitecturas que combinen criptografía clásica y cuántica.

Para reforzar la protección de secretos y transacciones sin revelar datos crudos, los protocolos de computación multipartita (MPC) también están viviendo un impulso. En conjunto, estas técnicas ofrecen un abanico de defensas que se complementan y permiten mitigar el riesgo a medida que la capacidad cuántica crece.

¿Procesadores cuánticos en casa? Lo razonable hoy es la nube

En el corto plazo, tener una QPU doméstica no es realista. Seguiremos con PCs y móviles clásicos durante mucho tiempo, mientras el acceso cuántico llegará por la nube. Esto se debe a varias barreras técnicas y operativas difíciles de salvar en un hogar o pyme.

Principales frenos para el uso doméstico directo:

- Refrigeración extrema: muchos diseños requieren temperaturas cercanas al cero absoluto; replicarlo en casa no es ni práctico ni eficiente.

- Corrección y mitigación de errores: los cúbits son muy sensibles al entorno; mantener tasas útiles exige entornos controlados y algoritmos sofisticados.

- Infraestructura especializada: los sistemas actuales ocupan salas con electrónica, blindajes y calibraciones continuas.

- Software y casos de uso: las aplicaciones generales están verdes; lo que ya aporta valor es formación, investigación e IA aplicada en dominios concretos.

Donde sí hay tracción es en QaaS. Plataformas en la nube permiten ejecutar circuitos, probar algoritmos y combinar flujos clásicos-cuánticos. Para el usuario medio no tiene sentido para ofimática o juegos, pero para equipararse, aprender y experimentar —especialmente en seguridad, simulación o optimización— es una vía útil. Ojo al coste y a la curva de aprendizaje: programar QPU requiere nuevos lenguajes mentales más allá de la lógica digital clásica.

Qué tecnologías de hardware están compitiendo

No hay una única forma de construir una computadora cuántica tolerante a fallos. Distintos tipos de cúbits exploran compromisos en fidelidad, escalabilidad y control, y varias líneas avanzan en paralelo.

Iones atrapados. Usan iones confinados mediante campos electromagnéticos; las puertas se aplican con láseres sobre estados electrónicos atómicos; estas técnicas también sustentan sensores cuánticos para navegación. Al partir de átomos «naturales», ofrecen coherencias largas, aunque escalar la conectividad requiere soluciones de arquitectura y enrutamiento.

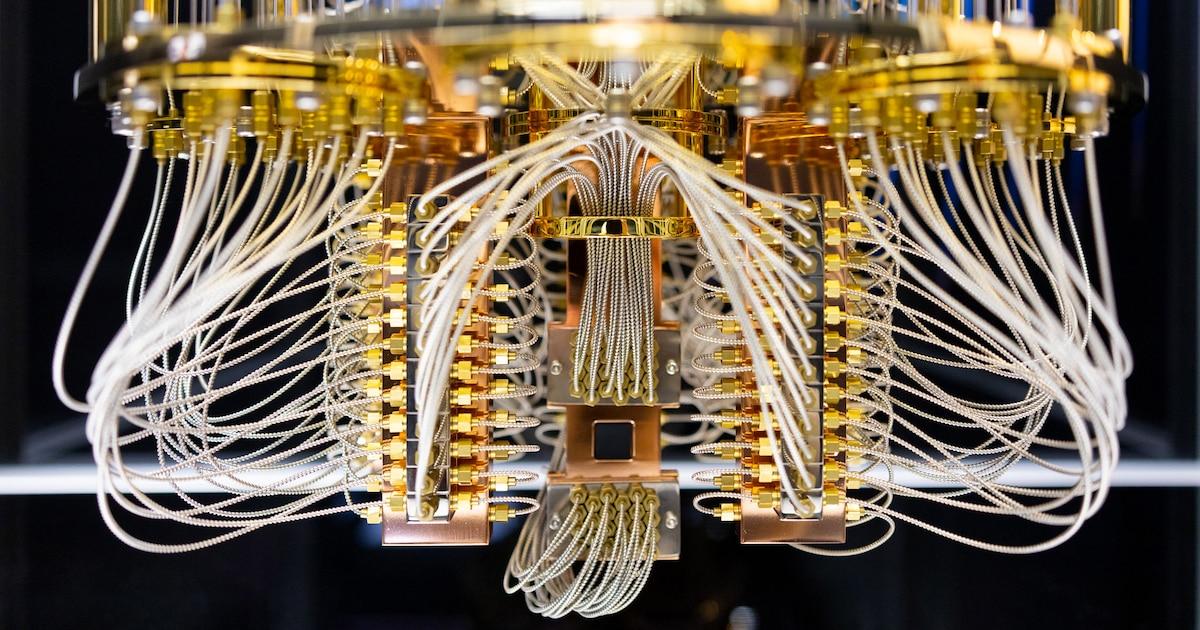

Superconductores. Circuitos superconductores a temperaturas criogénicas implementan cúbits controlados por microondas. Es la vía más visible hoy, con ecosistema maduro de fabricación e integración, y también la que demanda más esfuerzo en mitigación/corrección de errores y en el enfriamiento profundo.

Fotónica. Los procesadores fotónicos manipulan luz y modos continuos para computación cuántica y ciertas ventajas en comunicación. Presentan retos distintos en generación, detección y manejo de estados no clásicos.

Átomos neutros y estados de Rydberg. Atrapan átomos con luz y explotan interacciones ajustables seleccionando estados de alta energía (Rydberg). Prometen escalabilidad en arreglos bidimensionales y operación potencial a temperaturas menos extremas.

Temple cuántico (annealing). No es computación basada en puertas universales, sino optimización física hacia mínimos de energía. Permite hoy miles de cúbits físicos, con utilidad en problemas QUBO específicos (logística, energía, finanzas), aunque su aplicabilidad es más acotada.

Estado del arte: era NISQ, hojas de ruta y la carrera industrial

Vivimos aún en la era NISQ (Noisy Intermediate-Scale Quantum): cúbits ruidosos y en número limitado, lo que impide cálculos generales tolerantes a fallos. Aun así, fabricantes han mostrado que, con mitigación de errores, algunas QPU rinden por encima de métodos clásicos en tareas bien delimitadas, acercándose a la ansiada ventaja cuántica.

Se ven equipos en producción con más de un centenar de cúbits físicos: nombres de máquina como Fez (156), Torino (133) o Kyiv (127) son ejemplos del despliegue actual. Sobre estas bases, la siguiente ola se describe como supercomputación cuántico-céntrica: arquitecturas modulares que integran QPU, redes cuánticas y HPC clásico, coordinadas por middleware híbrido (incluyendo «tejido de circuitos» para reducir puertas de dos cúbits y latencias).

Hojas de ruta públicas apuntan a hitos ambiciosos: sistemas con decenas o cientos de cúbits lógicos tolerantes a fallos a finales de esta década —con objetivos de decenas o cientos de millones de operaciones cuánticas— y, más adelante, plataformas con miles de lógicos y escalas de mil millones de operaciones. En paralelo, la comunidad amplía acceso con programas en la nube inaugurados en 2016 para que cualquiera pueda probar circuitos y aprender.

Otras grandes tecnológicas y nubes públicas empujan en varias direcciones: desde cúbits lógicos con menos cúbits físicos en laboratorios de vanguardia, a alianzas con fabricantes de hardware cuántico y exploración de híbridos cuántico-analógicos. Empresas especializadas en annealing llevan años resolviendo optimización aplicada a gran escala.

En cuanto a casos de uso, voces relevantes del sector destacan que la sinergia con IA y aprendizaje automático será transversal: desde simulaciones de materiales, catálisis y baterías hasta modelos biomoleculares y energías renovables. Donde la cuántica reformula el problema, cambia la complejidad y aparece la ventaja. Un ejemplo clásico: multiplicar números enormes es trivial en clásico, pero factorizarlos con algoritmos cuánticos adecuados reduce drásticamente tiempos teóricos respecto a superordenadores.

Normas, regulación y ética: más allá de lo técnico

El cambio no es solo matemático o de hardware. Harán falta normativas y buenas prácticas que cubran desde privacidad, ciclo de vida de claves y retención de datos, hasta criterios de certificación de hardware, interoperabilidad y propiedad intelectual (por ejemplo, sobre aplicaciones de algoritmos cuánticos y su patentabilidad).

También hay cuestiones éticas: el riesgo de desigualdad si solo grandes corporaciones o países con músculo financiero pueden desplegar estas tecnologías; preocupaciones sobre vigilancia e interceptación si se masifica la capacidad de descifrado; y la necesidad de equilibrar desarrollo económico con protección de derechos y resiliencia social. Consorcios como QED-C y alianzas entre institutos punteros fomentan la colaboración para construir un ecosistema cuántico abierto y sostenible.

Los procesadores cuánticos serán una pieza central del cómputo del futuro, pero en modo híbrido y orientados a problemas muy concretos; su impacto alcanzará sanidad, finanzas, clima y logística, al tiempo que acelera una revolución en ciberseguridad que obliga a adoptar ya PQC, QKD y agilidad criptográfica. El hogar no verá QPU propias a corto plazo —la nube será el camino—, mientras industria, academia y reguladores ultiman estándares y hojas de ruta que marcarán la próxima década de innovación.