La expectación alrededor del Orange Pi AI Studio Pro no es casual: esta propuesta de cómputo para inteligencia artificial promete cifras que, sobre el papel, lo sitúan entre los dispositivos compactos más ambiciosos del momento. Entre lo más llamativo están los hasta 352 TOPS de potencia de inferencia y opciones de memoria que llegan a 192 GB LPDDR4X, todo dentro de un formato que, según distintas fuentes, oscila entre mini PC y módulo de aceleración conectado por USB 4.0, similar a otras SBC como Orange Pi 5 Ultra.

Aunque su músculo técnico impresiona, su adopción dependerá de factores que van más allá de las especificaciones: precio real fuera de China, disponibilidad en Europa/España, madurez del ecosistema software y claridad sobre su formato físico y conectividad. A continuación desgranamos, con detalle y sin humo, las características, el contexto de mercado y lo que se sabe de su comercialización.

Qué es exactamente Orange Pi AI Studio Pro y por qué importa

Orange Pi AI Studio Pro es presentado como una solución de cómputo de IA orientada a inferencia, basada en la familia Huawei Ascend 310 (en algunas menciones 310B). Mientras la versión AI Studio integra un único chip con hasta 176 TOPS, el modelo Pro “apila” dos unidades equivalentes para alcanzar 352 TOPS, además de doblar los recursos clave como la memoria (hasta 192 GB en el Pro frente a 96 GB máximos en el básico).

Aquí aparece la primera gran duda: algunas descripciones lo tratan como un mini PC convencional con conectividad amplia (red, USB, expansión PCIe, etc.), pero otras —incluida la documentación de producto en chino— lo dibujan claramente como un módulo con un único puerto USB 4.0 Type‑C y entrada de alimentación DC, sin HDMI ni Ethernet. Esta divergencia es clave para entender qué problema resuelve y cómo se integra en un flujo real de trabajo.

Su relevancia en el ecosistema llega por tres vías: por su densidad de memoria (hasta 192 GB LPDDR4X a 4266 Mbps en el Pro), por el empuje de Huawei en aceleradores Ascend para inferencia local, y por el precio objetivo en China, sensiblemente más bajo que estaciones con GPUs discretas de gama alta, al menos sobre el papel.

Más allá de la potencia bruta, la arquitectura Da Vinci del Ascend 310/310B está orientada a operaciones tensoriales eficientes en precisiones mixtas (FP16/INT8), lo que encaja con aplicaciones de visión por computador, análisis de vídeo multi‑stream y asistentes locales de lenguaje, entre otras tareas típicas de edge computing.

Ficha técnica: chips, memoria, potencia y formato

Orange Pi diferencia dos variantes: AI Studio (modelo base) y AI Studio Pro (doble cómputo). El corazón de ambas descansa en la familia Ascend 310, donde el modelo Pro integra dos unidades para duplicar el rendimiento y la memoria disponible.

Resumen de configuraciones y recursos, según la información compartida en las distintas fuentes oficiales y de terceros (incluida documentación en chino y listados comerciales): todo apunta a una propuesta centrada en inferencia con gran banda de memoria para alojar modelos exigentes.

- SoC:

- AI Studio: Huawei Ascend 310 (octa‑core ARM 64‑bit) con hasta 176 TOPS.

- AI Studio Pro: doble Ascend 310 con hasta 352 TOPS (16 núcleos CPU + 16 núcleos de IA en total).

- Memoria:

- AI Studio: 48 GB o 96 GB LPDDR4X a 4266 Mbps.

- AI Studio Pro: 96 GB o 192 GB LPDDR4X a 4266 Mbps.

- Almacenamiento:

- AI Studio: 32 MB de SPI flash.

- AI Studio Pro: 2 × 32 MB de SPI flash.

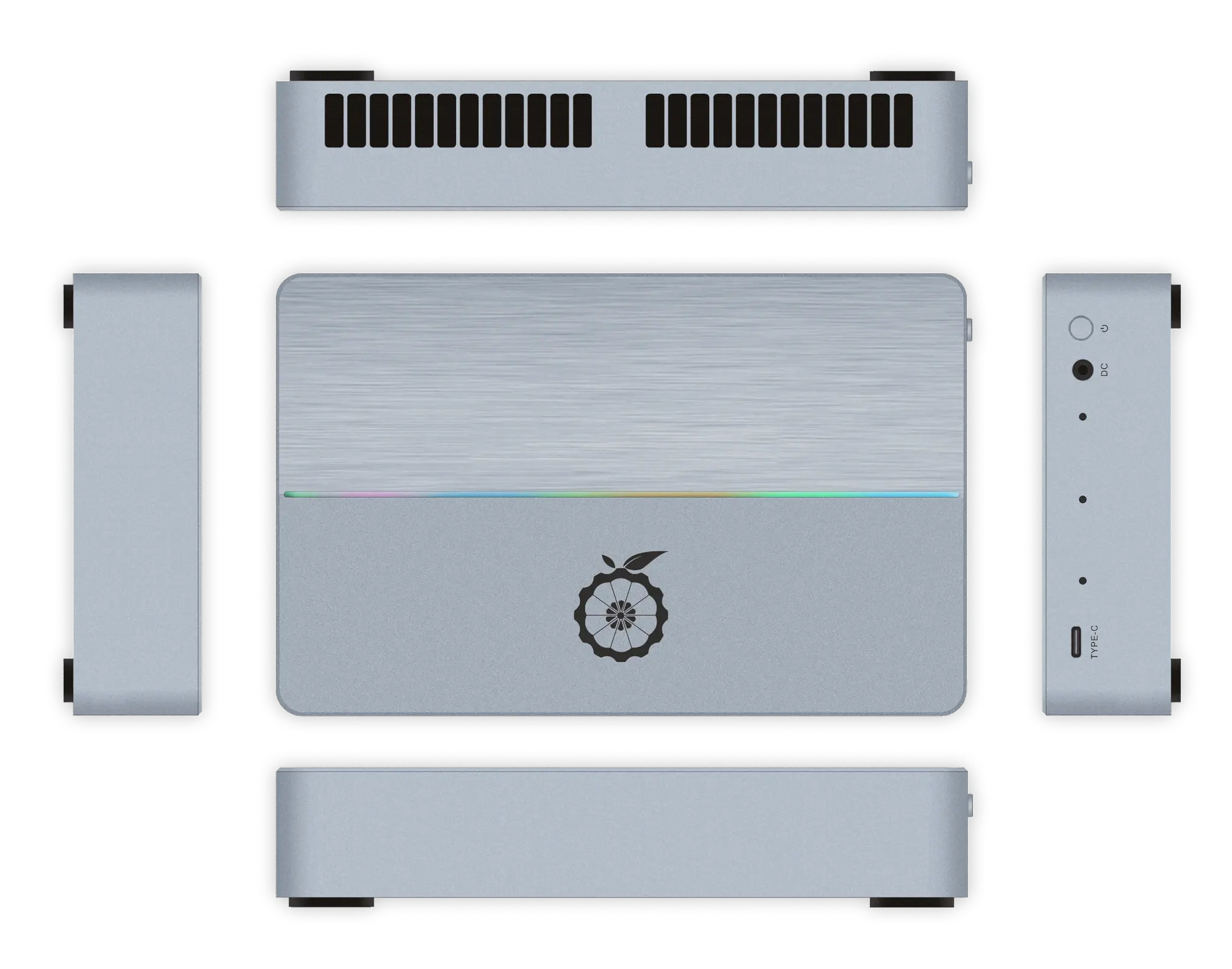

- Interfaces físicas: un USB 4.0 Type‑C, botón de encendido y un puerto para iluminación RGB (expansión), según ficha en chino; se indica ausencia de HDMI y Ethernet en estos modelos.

- Alimentación:

- AI Studio: 12 V 10 A (120 W) por jack 5.5/2.5 mm.

- AI Studio Pro: 12 V 20 A (240 W) por jack 5.5/2.5 mm.

- Dimensiones:

- AI Studio: 132.6 × 110.9 × 39 mm.

- AI Studio Pro: 207.7 × 132.6 × 40 mm.

- Sistema: soporte para Ubuntu 22.04.5, Linux 5.15.0.126 y Windows (próximamente); adicionalmente se menciona openEuler como base en diversos materiales.

Un detalle interesante es que el AI Studio Pro se describe como una especie de “dos AI Studio en un mismo chasis”, lo que teóricamente permitiría un apilado modular para formar pequeños clústeres. Este enfoque encaja con despliegues edge donde se busca escalar por nodos, aunque no se detallan topologías ni orquestación específica.

En contraposición, algunos análisis previos —no oficiales— hablan de opciones como PCIe 4.0, soporte para SSD NVMe, puertos USB 3.2, Wi‑Fi 6 y hasta Ethernet 10 GbE. Sin embargo, la ficha en chino de AI Studio/Pro y los listados técnicos reiteran un diseño de conectividad mínima (USB4 + alimentación), por lo que ese conjunto de puertos avanzados podría corresponder a otros equipos del ecosistema Orange Pi o a información aún no confirmada para estas variantes en concreto.

En lo eléctrico, se cita un consumo que puede rondar los 180 W en cargas elevadas, mientras que la fuente recomendada para el Pro asciende a 240 W, una cifra más cercana a un PC de escritorio que a una SBC tradicional, pero aún competitiva frente a estaciones con GPU dedicadas de gama alta.

Software, frameworks y compatibilidad

En el terreno software, la propuesta se apoya en el ecosistema de Huawei: MindSpore y la librería CANN (Compute Architecture for Neural Networks) ofrecen las bases para compilar, optimizar y desplegar modelos sobre Ascend. Esta capa es la que permite exprimir el hardware en inferencia con precisiones mixtas y kernels especializados.

Los sistemas mencionados incluyen Ubuntu 22.04.5 (kernel Linux 5.15.0.126), compatibilidad con openEuler y una promesa de soporte para Windows “próximamente”. Para TensorFlow o PyTorch nativos, puede ser necesario recurrir a adaptaciones, conversiones de modelos o toolchains específicos, algo que contrasta con la experiencia “plug‑and‑play” a la que muchos desarrolladores están habituados en CUDA/cuDNN/TensorRT de NVIDIA.

Este punto es crítico: aunque la potencia bruta y la memoria del AI Studio Pro son muy atractivas, la madurez del ecosistema (documentación, foros, ejemplos, wrappers, runtimes) va un paso por detrás de la plataforma de NVIDIA, lo que eleva la barrera de entrada para equipos menos familiarizados con Ascend.

Respecto a otros productos hermanos, el Orange Pi AIPro (20T) —un desarrollo distinto— soporta Ubuntu y openEuler, viene con 12/24 GB de LPDDR4X y un rico set de interfaces (HDMI dobles, M.2 para SSD 2280 SATA/NVMe, GPIO, puertos USB, LAN 2.5G, etc.). Este AIPro ilustra bien la diferencia de enfoque: más cercano a una placa de desarrollo polivalente que a un módulo de cálculo con USB4.

Rendimiento, precisión y eficiencia energética

La cifra de 176/352 TOPS no especifica oficialmente la precisión a la que se mide. Es razonable suponer que se refiere a INT8, mientras que valores en FP16/FP32 serían sensiblemente inferiores. Con LPDDR4X a 4266 Mbps, la plataforma está pensada para inferencia sostenida más que para entrenamiento de LLMs de gran tamaño, donde la combinación de cómputo y ancho de banda de memoria juega un papel determinante.

Para entrenar modelos extremos (p.ej., familias tipo GPT o DeepSeek de gran escala), algunos comentaristas sugieren optar por una GPU tope de gama (hasta mencionar hipotéticas RTX 5090) o soluciones con HBM y ecosistemas de entrenamiento maduros. En cambio, para despliegues en borde —detección de objetos, seguimiento, analítica de vídeo multi‑canal, ASR/TTS locales, RAG ligeros— el AI Studio Pro puede ofrecer una relación rendimiento/consumo y densidad de memoria muy competitivas.

Sobre el consumo, se manejan referencias a cargas pico cercanas a 180 W en escenarios exigentes, con una fuente de 240 W para el Pro. Un servidor con GPU profesional puede superar 400 W, por lo que, a igualdad de tarea de inferencia, el balance del AI Studio Pro es atractivo para entornos edge con restricción térmica y energética.

La arquitectura Da Vinci de los Ascend 310/310B prioriza kernels optimizados para matrices y tensores, con soporte para cuantización y mezcla de precisiones (FP16/INT8), lo que ayuda a mantener latencias bajas y throughput alto en pipelines de visión o NLP de tamaño medio.

Conectividad y diseño físico: el quid de la cuestión

La documentación en chino y los listados técnicos de AI Studio/Pro señalan un diseño minimalista: 1 × USB 4.0 Type‑C, botón de encendido, puerto de iluminación RGB y conector de corriente DC, sin HDMI ni Ethernet. Se refuerza así la idea de que es un acelerador conectado a un host, más que un mini PC autosuficiente con múltiples puertos.

Sin embargo, circulan descripciones que le atribuyen 10 GbE, Wi‑Fi 6, USB 3.2 y expansión PCIe 4.0, además de compatibilidad con SSD NVMe. Estas especificaciones no aparecen en la ficha minimalista y podrían corresponder a otros modelos Orange Pi o a configuraciones no documentadas públicamente para AI Studio/Pro. Conviene verificar el SKU exacto antes de comprar, especialmente si tu caso de uso depende de esas interfaces.

En términos de tamaño, el AI Studio mide 132.6 × 110.9 × 39 mm, mientras que el Pro crece hasta 207.7 × 132.6 × 40 mm, coherente con la integración de doble cómputo y con la necesidad de una fuente de alimentación más generosa.

Una mención repetida en comunidades técnicas es que, “por lo que se sabe”, no sería una mini computadora completa sino un añadido USB 4.0. Esta percepción coincide con la falta de vídeo y red integradas y encaja con el enfoque de “stacking” modular descrito para el Pro.

Aplicaciones objetivo y escenarios de uso

Donde mejor encaja el AI Studio Pro es en tareas de inferencia local con requerimientos de memoria elevados y latencia estable: visión por computador en tiempo real, analítica de vídeo con múltiples flujos, edge computing en smart cities, asistentes de lenguaje on‑prem y soporte a diagnóstico en salud cuando la nube no es viable por latencia o privacidad.

El diseño con USB4 apunta a despliegues donde un host (PC, NUC, servidor ligero) orquesta el pipeline y off‑loadea la inferencia. En entornos industriales, puede actuar como nodo acelerador acoplado a gateways existentes, reduciendo costes de migración.

También puede ser útil en laboratorios y universidades que quieran prototipar servicios de IA sin montar un clúster de GPUs, especialmente cuando la prioridad es el serving de modelos y no el entrenamiento desde cero, aprovechando la memoria para cargar modelos mayores y ejecutar varias instancias.

La limitación principal es el ecosistema: si tu stack ya está fuertemente anclado a CUDA/TensorRT, la curva de adaptación a CANN/MindSpore y la posible necesidad de conversión de modelos puede alargar plazos de integración.

Precios y disponibilidad: China, AliExpress y Europa

En el mercado chino, se han listado precios oficiales en JD.com: AI Studio por 6.808 RMB (48 GB) y 7.854 RMB (96 GB), y AI Studio Pro por 13.606 RMB (96 GB) y 15.698 RMB (192 GB). Además, se ha visto a la venta en AliExpress a partir de unos 2.350/2.640 USD (según configuración), aunque en ocasiones vía revendedores no vinculados directamente a Shenzhen Xunlong/Orange Pi.

En comunidades como Reddit se han mencionado reservas del Pro a ~2.600 USD (96 GB) y ~2.900 USD (192 GB), pero sin abundancia de reseñas en inglés y con referencias a envíos en semanas o incluso meses. Varios listados aparecen en preorder/backorder, reflejando un suministro todavía por consolidar.

En Europa/España, a fecha de la información recopilada, no hay confirmación de listado oficial del AI Studio Pro en distribuidores de la web internacional de Orange Pi, aunque sí figura en la web china del fabricante. Si se importa desde China, hay que añadir impuestos, aranceles y transporte, lo que eleva el coste final.

Como referencia de ecosistema, sí se encuentran en Europa variantes como Orange Pi AIPro (20T) —ojo, producto distinto— con precios que rondan los 187,60 € en algunas tiendas para configuraciones básicas (se citan 8 GB en cierto listado) y, en fichas más recientes, versiones de 12/24 GB. Este contraste subraya que el AI Studio Pro juega en otra liga de rendimiento y coste.

Con todo lo anterior, una estimación prudente para un desembarco oficial del AI Studio Pro en España podría moverse entre 2.800 y 3.500 € según memoria (96 vs 192 GB), márgenes, logística e importación. No hay, por ahora, una fecha confirmada de lanzamiento en Europa.

Comparativas: Jetson AGX Orin, GPU discreta y AIPro (20T)

Frente a Jetson AGX Orin, el AI Studio Pro se luce en memoria máxima (192 GB vs hasta 64 GB en Orin) y en teóricos TOPS (352 vs 275). No obstante, el ecosistema de NVIDIA —con CUDA, cuDNN, TensorRT y una comunidad masiva— sigue siendo una ventaja decisiva para acelerar la puesta en producción.

Si comparamos con un servidor con GPU discreta de gama profesional, el AI Studio Pro puede ser más contenido en consumo y más sencillo de encajar en edge, pero entrenar modelos grandes seguirá siendo terreno de GPUs con HBM/ancho de banda y toolchains dominantes. En inferencia, especialmente a INT8/FP16 y con modelos optimizados, el AI Studio Pro tiene sentido por su densidad de memoria y coste relativo.

Respecto al Orange Pi AIPro (20T), hablamos de propuestas distintas: el AIPro es una placa con 20 TOPS, 12/24 GB de LPDDR4X y una conectividad muy rica (doble HDMI, M.2 2280 para SATA/NVMe, USBs, 2.5G LAN, MIPI, etc.), pensada para prototipos y desarrollo general. El AI Studio/Pro, por su lado, prioriza el cómputo de inferencia y la memoria, con menos puertos según sus fichas.

Dudas abiertas y riesgos de adopción

Dos frentes concentran la mayor incertidumbre. Primero, el software: aunque CANN y MindSpore avanzan, la inercia de CUDA y la falta de igual madurez en documentación, ejemplos y soporte de frameworks mainstream pueden frenar la adopción fuera de China, al menos a corto plazo.

Segundo, la disponibilidad internacional: políticas comerciales, aranceles y tiempos de envío complican la compra. Algunos listados aparecen como preventas con entregas a semanas/meses vista, lo que introduce riesgos para proyectos con plazos ajustados.

Además, persiste la ambigüedad sobre el formato exacto (mini PC con I/O completo vs módulo con USB4), con la documentación más explícita inclinándose por la segunda opción. Antes de comprometerse con una integración, es vital confirmar puertos, OS soporte y toolchains para el caso de uso concreto.

Con todo, si se consolida una red de distribuidores fiables en Europa, llegan más reseñas públicas y mejora el tooling para frameworks populares, el AI Studio Pro puede convertirse en un referente de inferencia en el borde por su equilibrio de potencia, memoria y consumo.

Queda un panorama prometedor pero con matices: un equipo con 352 TOPS, hasta 192 GB y diseño compacto que brilla en inferencia, precios atractivos en China y presencia en AliExpress, aunque sin despliegue europeo claro; un ecosistema software en evolución (CANN/MindSpore, Ubuntu/openEuler y promesa de Windows) y dudas razonables sobre conectividad real, por lo que lo sensato es validar SKU, puertos y soporte antes de comprar, calcular costes finales con impuestos y aranceles, y asumir posibles demoras de suministro.